您现在的位置是: 首页 > 网络营销 > 正文

生财有术钱塘江鲤:AI自动化内容采集、选题、生成图片、发布分发、串联,实现内容获客10倍提效!

发布时间:2025-08-15 21:26:00 编辑:admin 浏览:1296

大家好,我是钱塘江鲤,是AI数据相关方向的从业者,主要做的是为垂类模型,提供行业专业数据和合成数据,同时协助企业进行AI落地。

听到这里,大家会有点好奇:一个做AI数据的,怎么会分享AI+自动化提效这个话题呢?

这其实正是我今天想传递的一个核心信息——利用AI和自动化来提升生产效率的门槛,比我们想象的要低得多。

今天分享的部分内容,可能涉及到一些代码,但99%都是AI生成的。即使遇到一些问题,也可以借助模型能力进行迭代和修复,所以并不需要大家有很过硬的技术背景。

现在AI的能力非常强大,只要思路对了,复现和应用起来就会非常快,完全不用担心无从下手。

做内容的整个流程中,从爆款采集、对标到内容生成、发布、数据回收等,70%的时间都浪费在重复劳动上。

但是我如果说:这些工作,现在AI都能帮我们搞定呢?

这就像多了一个24小时不眠不休的硅基员工。以前我们得手动复制粘贴、整理数据、翻评论区挖用户需求、找选题方向——现在,只要是人能在电脑上完成的动作,几乎都能实现自动化。

所以我的判断是,未来在内容领域,凡是靠人力重复堆砌的工作,一定会被AI+自动化取代。这不是要不要的问题,而是谁先掌握,谁就能十倍领先的生存法则。

Part 1

什么是自动化,

如何实现自动化?

简单来说,自动化就是用技术代替人力,把那些重复又机械的活交给机器处理——我们只需要动脑,专注在更有价值的事情上。

用好自动化加上AI,其实就等于给团队招了一个数字员工,它像一个超级杠杆,能成倍放大我们的业务价值。

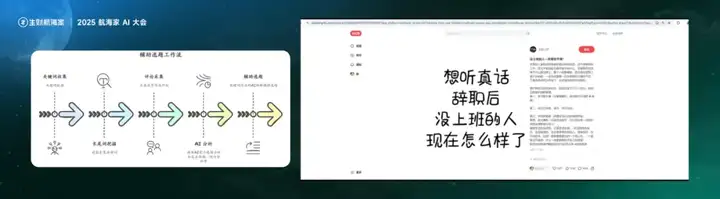

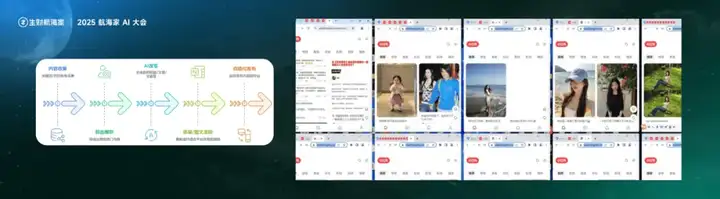

比如大家可以看下面这个基础的自动化工作流,这是现在最常见的一种玩法:我们设定好关键词或者对标账号,自动去小红书、抖音上抓取爆款内容,筛选出表现最好的数据,把视频文案保存到飞书表格,再通过飞书AI自动生成配图,最后一键分发到小红书、飞书、抖音公众号等平台。

整个流程几乎是全自动跑完的,人只需要在关键节点上做个质量检查。

这样一来,我们的运营效率完全不一样了——用很小的成本,就能跑出超预期的转化效果,变成了我们低成本测试、快速获客的利器。

01

低代码应用集成自动化平台

首先是低代码的应用集成自动化平台,比如 Zapier、n8n、Make,它们通过“触发器+动作”的机制,把不同的应用串联起来。

比如我在Notion写了一篇笔记,它可以自动同步到 Twitter。

这类平台的优点是上手快、门槛低,几乎零代码,适合个人或小团队,处理一些简单的跨平台联动任务。

但它的缺点也比较明显:作为国外平台,对国内工具的生态支持并不完善,同时也很难通过预设模板来支持复杂的业务流程。所以最终用不用,还是得看具体的应用场景来决定。

02

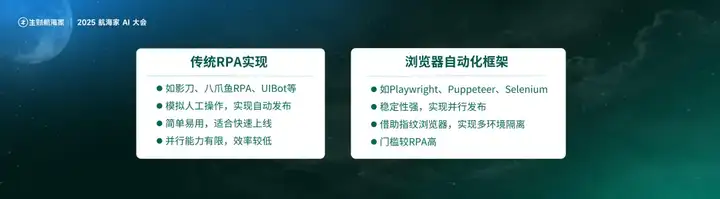

传统RPA

接下来是传统的RPA工具,比如八爪鱼RPA、影刀RPA,它们通过可视化的指令拖拽来实现自动化流程。

优点是基于本地运行,可以接管键盘和鼠标,模拟人工操作,完成整套流程;而且上手门槛低,半天就能入门。

但它也有一些限制,比如在某些场景下运行不够稳定,自定义调度也比较困难,不太容易集成进现有的工作体系。不过整体来看,它仍然是一种相对均衡、适配面较广的自动化方式。

白杨SEO补:延伸阅读,关于NOTION、RPA等是啥看:

claude、notion、mj、sd、suno、sora、cursor、agent、coze、rpa、ai、seo是什么?必看

03

AI工作流平台

再往下是在线工作流平台,通过拖拽形式将不同环节串联起来。

比如输入一个链接或一篇文章,就可以自动生成不同风格、不同调性的文案,形成完整内容。

这类方式适用于内容创作类的自动化,但个性化实现成本依然偏高,对复杂逻辑的支持有限,多工作流协同能力较弱,并发场景下的稳定性也存在问题,整体算是一种适合入门、轻量化使用的工具。

白杨SEO补:延伸阅读,关于AI工作流可以看:

AI工作流是什么?coze扣子工作流怎么搭建和使用?【参考】

04

AI编程

下一种方式,是利用AI编程,实现脚本化或产品化的自动化——比如使用Cursor这样的AI IDE,自行编写自动化脚本。

这种方式灵活性极强,可以根据需求定制复杂的自动化工作流,比如我就用AI编程实现了同时采集多个平台数据,再用AI进行趋势分析、内容生成和分发。

它最大的优势是高度可定制,能应对各种复杂业务场景,但前提是你具备一定的编程能力,对初学者来说不算友好。

当然,它还有一个核心优势,就是可以稳定支持大规模并行处理,短时间内完成高强度任务密集执行。

05

全自主Agent-如Manus

再往后的形态,是类似Manus这样的全自主Agent。

我认为,自动化的最终形态,很可能就是这种方式——我们只需要下达一个指令,它就能自动拆解任务,调用不同的工具完成执行,并最终交付结果。

比如我告诉它:做一份关于RPA的调研PPT,它会自动检索信息、整合内容,很快给出成品,甚至不需要我们事先编排流程。

它的优势在于简单、高效,并具备一定的自我扩展能力,可以联动多个平台、整合不同数据来源。

当然,目前这类工具在可控性和成熟度上仍有待提升,但随着大模型能力增强、产品不断迭代,这些问题最终都会被解决。

到这里,我们已经聊了几种自动化的实现路径——从低代码平台,到RPA,再到AI编程,最后是全自主Agent。

每一种方式都有自己的优势与局限,关键是结合实际需求,找到最适合自己的实现方案。

接下来,我们就进入实战部分:怎么用自动化,解决内容运营中的真实痛点。

Part 2

自动化采集

那我们该如何在实际场景中运用自动化,解决真实问题呢?

第一个典型场景,就是自动化采集。

当我们要做爆款内容时,最重要的一步就是先搞清楚:什么内容能跑量?哪些内容转化高?这时候就必须采集足够多的数据。

某种程度上来说,全网的爆款内容,其实就是用户真实需求的映射——全网爆款 = 现成的用户需求数据库 = 你的流量密码。所以第一步,肯定是先采集高质量的数据。

这些数据来源可以覆盖全球,比如YouTube、Twitter、Reddit,也可以是国内的抖音、小红书等平台。

通过采集这些数据,建立自己的中心素材库,就可以快速围绕爆款内容做二创,也可以借助AI进行选题挖掘。

说到数据采集,大家可能会想到很多方式,比如低代码的采集工具,像八爪鱼、后裔采集,或者传统的RPA工具;也可能是基于浏览器的自动化工具,比如Web Scraper、Automa,甚至更高级的方式,如逆向、代理网络爬虫等。

但这些方法要么上手门槛高,要么采集效率偏低。那么有没有一种方式,能在效率和易用性之间找到平衡?

这里我推荐一个组合方案:Cursor + Playwright。

Cursor大家都不陌生,之前在生财里就有很多用Cursor做出的经典产品案例。而 Playwright 是什么?你可以把它理解为一个自动化测试框架,也可以看作是基于浏览器的 RPA 工具。

它能并行打开多个浏览器窗口,实现全自动操作,不管是用于数据采集、内容发布,还是任何浏览器端的自动化任务,都能很好地适配。

举个例子,这是亦仁老大去年12月发布的关于YouTube Shorts的超级标。我当时看到帖子后,当晚就写了一个简单的脚本,第二天就已经采集了十几万条视频,最终筛选出1万个相关频道。

可以看到,这套流程逻辑其实和RPA很像:先打开网页,找到搜索框,输入关键词,或者直接点击tag,定位到所有相关视频,再模拟人工点击和滚动,拿到需要的数据。

我们可以同时启动50个浏览器进行采集,每个浏览器之间环境是隔离的,相当于在一台电脑上开出多个AI工位,每个工位分配一个AI牛马,专门负责采数据的活儿。

这里顺便告诉大家一个冷知识:像YouTube这种全球性的平台,是支持IPv6的,而IPv6的IP 成本很低,所以我们可以几乎零成本、无限量地采集YouTube等平台的数据。

那这种自动化采集到底怎么实现?我这里演示一下,如何在十分钟内完成一个这样的采集脚本。

Cursor 能根据我们的需求,一次性生成脚本并完成数据采集,整个过程不到五分钟,脚本直接bug free一次性跑通。

即使真的遇到问题,在 AI 模型能力不断进化的今天,也很容易调试解决。是不是感觉没那么难?

所以很多时候。门槛真的没想象中那么高,只要你愿意动手试一下。

同样的采集方法,其实也可以轻松扩展到国内的平台。

我们只需要稍微改造一下刚才用于 YouTube的采集脚本,整个浏览器调度的模块是完全一致的,只要根据不同平台写不到100行的代码,就可以迁移。

以小红书为例,我们就可以用类似的方式来进行数据采集。

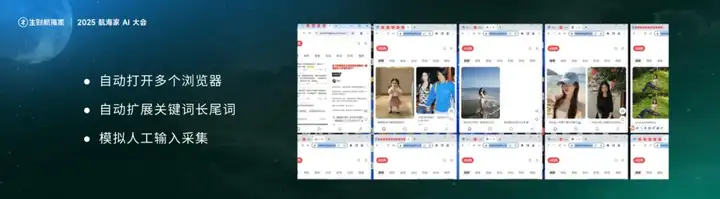

大家可以看这个演示,系统自动打开了10个浏览器,模拟人类在小红书中输入关键词,首先获取 A-Z 的所有长尾词,然后逐个开始采集。这种方式还有一个优势,就是可以有效避开风控机制,提高整体采集效率。

同样的逻辑也可以拓展到其他任意平台。

这是我日常使用的看板控制台,大家可以看到上面展示了各类数据源的原始数据,它会根据我设置的关键词和感兴趣的话题,在全网范围内自动搜索并采集相关内容。

此外,还有一些通用的热榜信息,比如公众号热榜等,也都同步到了我的看板系统。

右侧则是我基于关键词或关注博主采集到的推文信息,还包括根据关键词在全网检索到的新闻内容,并自动通过 AI 做摘要和总结——一方面方便我快速了解行业最新动态,另一方面也为内容创作提供了高质量的素材来源。

这样一来,当你的竞品还在手动刷热点、手动采集数据的时候,你的一台电脑上已经有上百个浏览器组成的 AI 打工人,有条不紊、分工协作地帮你从各大平台高效采集所需数据。

Part 3

自动化选题

接下来是选题挖掘的自动化。要知道,原始数据 ≠ 价值,真正有用的,是如何借助 AI 对采集到的爆款笔记和评论进行分析。

关键在于,现在这件事的成本已经低到惊人。

这都得益于大语言模型价格的不断下降,比如 Gemini Flash 2,每百万输出token仅需0.4 美元,一杯咖啡的钱,就能调用一千 token,足以分析五百条笔记和评论。

通过饱和式生成,我们可以让 AI 源源不断地产出选题灵感——大力出奇迹。

所以我一直觉得,人工找选题像钓鱼,要靠耐心和运气;而AI找选题,是直接把整片海抽干,把大鱼小鱼一网打尽。

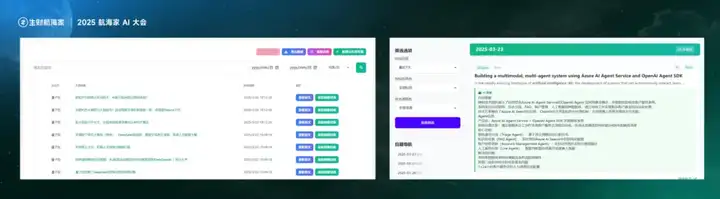

比如在前面提到的笔记采集流程中,我们可以设置条件,比如点赞或评论数超过某个阈值,就将对应的评论信息全部采集下来。

接着从多个维度进行分析——选题方向、用户需求、评论区详情等等,最终生成新的选题。

这些自动生成的选题报告非常有价值,完全可以每天产出数百个高质量选题,供团队选择。

来看一个具体的案例:他们从选题方向出发,结合评论区的情感比例,做了一定的分析。

我们可以看这个例子——AI采集了一篇爆款笔记《没上班的人一天都在做什么》,然后对笔记和评论区进行了分析。

评论区有 3000 多条评论,AI 分析出了评论倾向、主要观点总结、评论类型分类、用户需求拆解等内容。大家可以看到,AI 从多个角度给出了原始分析内容。

比如,AI 的选题建议中提到:87% 的评论都在说“刷手机刷到焦虑”,高频关键词是“不知道能做什么”。

这说明什么?说明用户真正关注的,可能并不是猎奇内容,而是实实在在的解决方案。

于是,AI 自动生成了若干选题建议,比如:

❖

《裸辞自救指南》——解决“目标感缺失”问题

❖

《零成本副业实操》——对应“想赚钱没门路”的用户

❖

《自由职业时间表》——回应“虚度光阴”和“愧疚感”焦虑

最终,AI 结合爆款笔记,自动生成了标题如《裸辞空窗期自救指南》《5个零成本副业实操手册》的选题内容。

整个过程中没有任何人工介入,AI已经自动完成了从数据分析到选题产出的全过程,真正实现了选题挖掘的自动化。

再比如这条笔记案例:“说一个身边只有你用的小众 APP”。这条笔记下有1.6万条评论,AI 在采集之后也自动进行了分析。

比如,AI 从评论中挖掘出了一些刚需信息:有人在找免费 PDF 编辑工具,有人提到外卖返利神器,还有大量评论出现了“求推荐”这样的表达。

基于这些反馈,AI 给出了相应建议:既然有用户在评论区怒吼“被 PDF 软件搞崩溃”,那就应该马上产出《免费工具大全》;又比如,高频词中出现了“二手平台”,那就可以快速推出《闲置变现攻略》。

整个过程同样无需人工干预,AI 能够自动识别需求、生成选题,真正实现了从数据到内容的高效转化。

甚至可以说,这已经不是“选题”了,而是用户举着喇叭在告诉你:“我要这个!”

因为我们所用的,是用户在评论区亲自留下的吐槽和需求数据,还有什么比这更精准的呢?其中很多痛点,可能是我们平时根本想不到的。

如果靠人工去筛选、逐条研判,每条笔记的评论区至少要花上半个小时。

但通过自动化,我们可以每天稳定分析100条以上的爆款笔记,自动生成高质量选题,直接同步到飞书——甚至连初稿都已经自动生成,整体效率提升10倍都不止!

Part 4

自动化生成图片

前面我们讲到了爆款内容的采集和选题的自动化,下一步就是生成内容形式,比如自动生成图片,或者通过数字人来进行分发。

这里我们可以先讲一个最简单、效果却最好的图文创作形式。随着DeepSeek V3最新版本的推出,现在在前端的生成效果上,已经和 Claude 3.7不相上下了。

那我们能不能把采集来的爆款文案,或者从抖音视频中提取出的文案,批量化地用于图片创作呢?毕竟一个一个做,实在是太麻烦了。

比如这个飞书表格,就是我们在上一个步骤中采集并提取出的所有对标短视频文案。

我们在表格中新增一列,命名为“AI 生成小红书封面”,然后选择DeepSeek最新的V3模型,提示词用的是归藏老师的开源提示词,接着直接批量生成,就可以得到卡片源码。

比如这次我采集了大约8 条对标文案,在几分钟内,系统就自动生成了所有的卡片源码。随后,我们通过自动化流程解析这些源码并转化为图片。

大家可以看下这个效果——从采集对标视频文案,到生成小红书的高质量图文封面,整个流程处理了80多条内容,总共耗时不到20分钟,这个提效速度应该已经非常可观了。

而且这个应用场景,并不仅限于生成小红书封面,我们还可以新增一个AI列,用于生成正文图片、公众号首图等等。

甚至可以把社群内所有成员的自我介绍,汇总成一列,在几分钟内批量生成上百张AI名片或荣誉证书,效率极高。

那成本呢?大家可以看下这个结果:我总共生成了100多条内容,包括测试用的提示词在内,总成本只有0.91元。

结合生成的图片质量来看,整体是完全可以接受的。

实际上,这种形式不仅适用于小红书套图或公众号图文生成,在社群运营中同样实用——比如为社群成员批量生成个性化名片或荣誉证书,哪怕是1000个用户,也能在几分钟内全部生成、保存或分发。

所以从综合成本和使用效率来看,这种方式对我们来说是一个非常大的提升。

Part 5

自动化分发

下一个场景是“发布”——内容生产的最终目的,是触达目标受众。

但一旦内容制作完成,真正的挑战才刚刚开始:我们往往需要把内容,上传到十几个不同的平台,每个平台下面还可能挂着几十个账号,发布过程往往是半手动,甚至完全手动完成的。

而这种重复性极高的操作,恰恰是最适合自动化发挥作用的地方。如果我们想实现全链路自动化,内容的高效分发就变得至关重要。

那要怎么实现呢?通常有几种方案。一种是使用RPA工具,比如影刀;另一种是使用 Playwright 这样的浏览器自动化方式。

后者的优点是稳定性强、支持并行发布,而且可以实现环境隔离,避免账号间的干扰。

下面这个就是我用影刀,从零搭建的一个公众号自动发布流程——只需要从左边拖拽相关的指令,一步一步配置流程即可。

整体上手门槛不高,这只是一个简单示例,是我为了演示加的流程,可能还不够完整,但整个过程不到半小时就能搭建完成。

接下来是第二种方案——浏览器自动化,比如 Playwright或Selenium。我们在前面的数据采集部分也已经展示过。

这种方式的特点是:我们可以在一台电脑上同时打开几十个,甚至上百个浏览器,相当于开启了100个虚拟工位,每个工位都在独立运行。

有的在小红书上传图片,有的在抖音发布视频,有的在Twitter发布thread,甚至还有的在同步到 Pinterest。

关键在于,这些浏览器之间的运行环境,是完全隔离的,就像为每个账号准备了独立的“工作间”。

即使这些工位,都在执行同一个平台的任务,也可以通过配置独立 IP,实现账号与环境的完全隔离。

这种方式尤其适合需要大规模、多平台矩阵发布和高频内容输出的场景,比如社媒矩阵获客、跨境电商推广、独立站引流等。

下面是一个简单演示,用Playwright从零搭建公众号自动化发布流程。

在这里我们可以使用Playwright的codegen功能,只需要手动操作一遍流程,系统就能自动生成代码。我们再将其复制粘贴到 Cursor 中,稍作修改即可使用。

当然,这种方式相对来说有一定的技术门槛,难度也比 RPA 略高一些。

综上可以看到,借助自动化,我们已经可以实现从养号、采集、改写、选题到发布的全流程闭环,运营效率实现了指数级的提升。

但在最后,我还是想强调一点:AI 只是工具,内容的核心价值,依然来自于“创造”本身。

虽然自动化能大幅提升效率,但我们必须始终记住,AI 是提效工具,不是制造垃圾内容的机器。它无法也不应该完全替代人的工作。

自动化前,我们要做好人工验证,明确任务目标;自动化后,也需要人工监控,确保流程正常运行、及时调整。

即便是高度自动化,依然不是100%自动化,人机协同才是未来的主流模式。

其次是对原创的尊重——二创和改写必须有足够的创新,不能简单复制他人内容。我们真正追求的,不是堆砌内容数量,而是通过自动化解放人力,把时间和精力,集中在真正能创造价值的事情上。

Part 6

AI+自动化串联

刚刚我们说到了实现方式,以及AI+自动化在我们常见的运营场景中的一些优化,下一步就要把工具串联起来,作为一个全自动工具,帮助我们完成任务。

01

案例一

爆款文案提取工作流,实现从视频平台批量提取文案信息,半小时内提取500多条视频文案,并进行不同风格改写。

相比人工提取(每小时约60条),实现了20倍提效。

02

案例二

公众号批量发布工作流,根据关键词扩展出大量相关主题,批量生成文章内容后,自动发布到公众号。

通过并行发布机制,实现低成本SEO优化,吸引精准流量。

03

案例三

Twitter爆款二创工作流,采集Twitter热门Thread,自动化改写、翻译并发布。

人工流程约需1小时/条,通过自动化后缩减至2分钟/条,一个半个月内,多篇内容获得数百万曝光量。

Part 7

总结

其实,AI自动化的应用,远不止于内容生产或获客。在跨境、电商、社群运营等领域,AI自动化还有更多可以大展拳脚的场景,远远超出我们今天展示的这些案例。

可以说,今天我们看到的,仅仅是AI自动化的一个开始。

希望大家能从这些实操案例中,找到适合自己业务的切入点,从一个小小的工作流开始,逐步构建属于自己的 AI 自动化体系。

我也非常期待在未来的交流中,听到你们用自动化跑通流程、提效业务、实现突破的成功故事。

你想了解更多AI相关的内容?

这边为你准备了《生财有术20个AI项目合集》,其中涵盖了大量AI项目,以及相关的应用场景。

扫描下方二维码,添加生财服务官微信,回复【AI888】即可领取。

相关推荐:

多账号管理与自动化必备工具-AdsPower指纹浏览器【介绍、使用教程及优惠码】

关键字词: